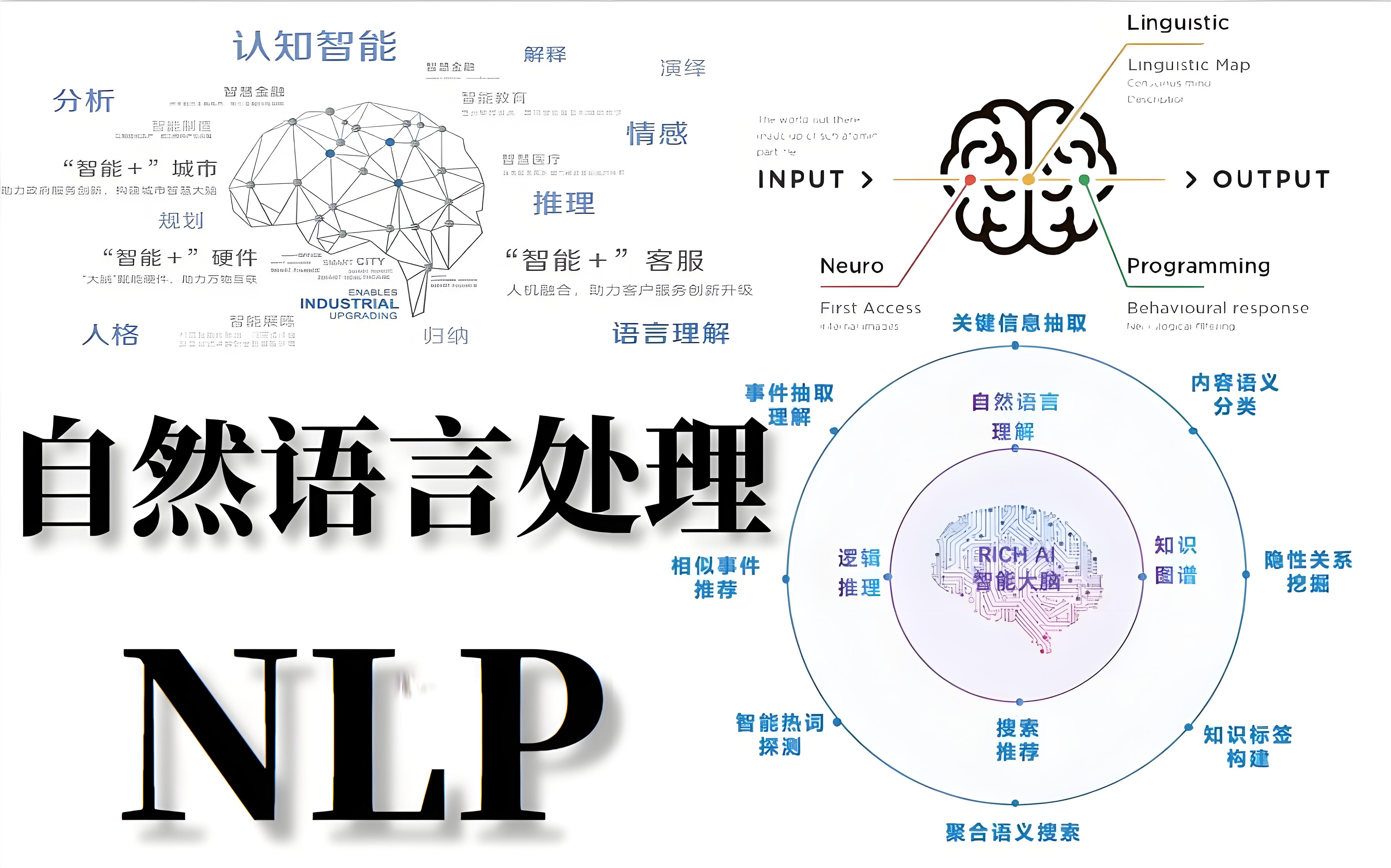

自然语言处理 lec8 dp

Syntactic Analysis IIDependency StructuresStructures

成分树:根据语法,哪个词应该和哪个词合起来

而Dependency则从宏观到微观逐渐观测,什么和什么相关 e.g.我喜欢什么,我喜欢吃什么,我喜欢吃什么样的苹果…

Predicate-Argument Structures(谓词论元):

重点考察核心的谓词之间的关系,左边是成分,右边是依存。通过依存关系来刻画意思,角色之间存在重要性的差异

In the words by Lucien Tesni`ere

句子是一个有组织的整体,其构成要素是单词

在单词和它的邻居之间存在联系,这些联系的整体构成了句子的结构

结构连接在单词之间建立依赖关系。原则上,每个连接都结合了一个上级项和一个下级项,单向的,从head -> dependency

词法项通过二进制不对称关系链接,称为依赖项

Dependency Structures

Terminology

Superior: Head/Governor(控制作用)

Inferior: Dep ...

自然语言处理 lec7 phrase

Syntactic Analysis ISyntactic Structures

讨论了词义消歧、语言模型序列(这句话好不好)、序列标注(词性是否符合语法习惯)

我们没有触及另一个有趣而复杂的话题:语法

Syntax

语言遵循一定的语法规则(隐性的),而且会不断变化:

可以编译的有一定规则和形式

没有歧义,他人能懂

同时附带语义

超越字级分析或纯序列分析

分析语法的一种可能解决方案是将句子映射到复杂的结构中(句法分析),例如树或图形。希望讨论的不再是序列而是更复杂的结构——树或图…

所需:设计计算解决方案来恢复这些具有挑战性的句法结构

来自语言学的一个很好的理论,希望能完美地描述所有的语言现象

一种将句子映射到某些目标结构的算法

目标结构的形式可以多种多样,例如序列、树、图形等

目标结构的形式可以多种多样,例如序列、树、图形等

需要一个方法来评价好坏

Theories

句法结构(语法):管理单词序列的语法或格式正确的规则,通常与某种语言有关

语义:单词、短语、句子或段落的含义是如何构建的,如何基于世界或世界的近似值(意思如何聚合)

语用(上下文相关): ...

自然语言处理 lec6 sper

HMM POS TaggerElements in HMM POS Tagger

Elements:

a sequence of words

a sequence of POS tags

the beginning and end of a sentence

参数:

Sequences of POS tags → transition probabilities (p(yn|yn−2,yn−1))

Co-occurrences of words and POS tags → emission probabilities (p(xn|yn))

A Naive Way to Incorporate

可以加入先验知识

考虑多种特征的方法需要优化多个lamada

Alternative: A Classifier

每一个词进行分类,然后抽取特征,根据特征找到最好的POS标签

log-linear可以用于这个分类任务,但是效果并不好。问题:逐个词抽取特征,没有办法利用前后词特征

individual decisions v.s. a sequence of decisi ...

自然语言处理 lec5 hmm

Sequence Tagging I- Hidden Markov ModelsGenerative Models v.s. Discriminative Models

Generative Models – Naive Bayes:

可能需要多个相关决策并且了解他们的背景,任务可以拆成小的决策,最后聚合成为大的决策:类似于抽取器,抽取特点,进行预测

Discriminative Models –Log-Linear model:

更好地适应拥有大量标注数据的目标决策场景,找到可以区分的特征,例如狗带项圈

The Sequence Tagging Problem

给定一个序列的项目,任务是针对序列中的每一个词标注决策对最后的任务有没有帮助,挑选出有帮助的部分

最终小的分类决策可以聚合成复杂结构

常用于语言标注、语音标注、词性标注、分词、切出名词块、大小写分析、口音恢复、信息抽取

NP Chunking and Named Entity Recognition

输入:一句话;输出:每个词给出词性标注

Noun phrase chunking:找到句子中的 ...

PERSONALIZED VISUAL INSTRUCTION TUNING

PERSONALIZED VISUAL INSTRUCTION TUNINGABSTRACT

多模态大语言模型(MLLMs)取得了显著进展,但这些模型存在一个明显的局限性,我们称之为“脸盲症”(“face blindness”)

它们能够进行一般性对话,但无法针对特定个体展开个性化对话。这一缺陷限制了MLLMs在个性化场景中的应用

本文提出个性化视觉指令调优(PVIT),这是一种新颖的数据构建和训练框架,旨在使MLLMs能够识别图像中的目标个体并进行个性化和连贯的对话

我们的方法包括开发一个复杂的流水线,自动生成包含个性化对话的训练数据。该流水线利用了多种视觉专家模型、图像生成模型以及(多模态)大语言模型的能力

为了评估MLLMs的个性化潜力,我们提出了一个名为P-Bench的基准测试,涵盖不同难度级别的多种问题类型。使用我们构建的数据集进行微调后,模型的个性化性能得到了显著提升

1 INTRODUCTION

大语言模型(LLMs)的出现显著推动了人工智能的发展,改变了自然语言处理和理解领域。这些模型在大量文本语料库上训练,拥有丰富的世界知识,能够出色地完成各种任务

L ...

MyVLM:Personalizing VLMs for User-Specific Queries

MyVLM:Personalizing VLMs for User-Specific QueriesAbstract

大规模视觉语言模型(VLMs)在理解和生成视觉内容的文本描述方面展现出了卓越的能力

然而,这些模型缺乏对用户特定概念的理解

我们首次尝试个性化 VLMs,使其能够学习并推理用户提供的概念。例如:模型是否能够学习识别图像中的“你”,并描述你的行为,从而使模型能够反映你的个人经历和人际关系

为了有效识别多样化的用户特定概念,我们通过外部概念头(concept heads)增强VLM,这些概念头作为模型的开关,使VLM能够识别给定图像中特定目标概念的存在

识别概念后,我们在VLM的中间特征空间中学习一个新的概念嵌入(concept embedding)

该嵌入的任务是引导语言模型自然地将目标概念整合到其生成的响应中

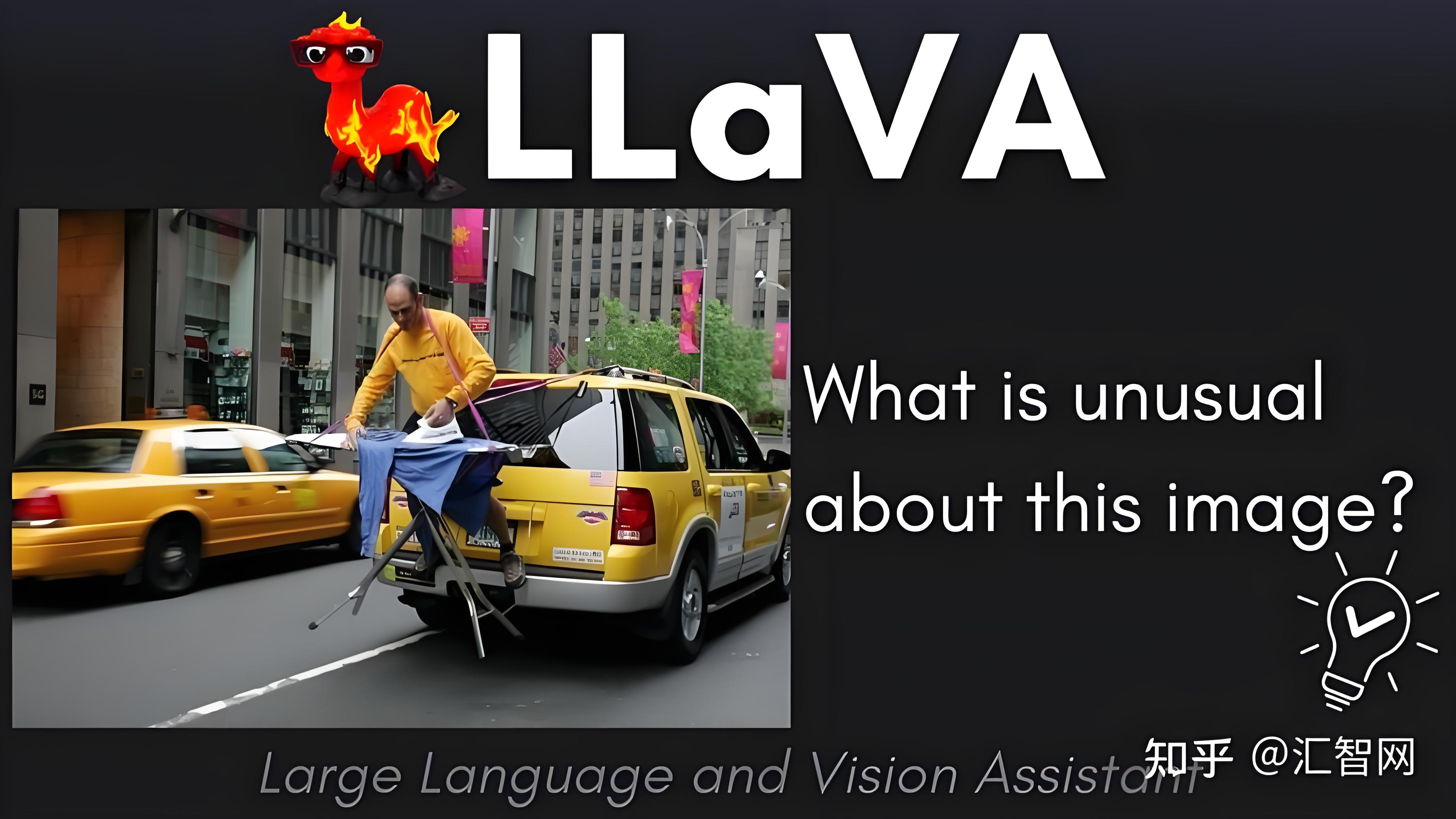

我们将该技术应用于BLIP-2和LLaVA以实现个性化图像描述,并进一步展示其在个性化视觉问答中的适用性

实验表明,我们的方法能够泛化到已学习概念的新图像,同时保持模型在无关输入上的行为不变

项目页面:https://snap-research.g ...

Yo'LLaVA:Your Personalized Language and Vision Assistant

Yo’LLaVA: Your Personalized Language and Vision AssistantAbstract

大型多模态模型(Large Multimodal Models, LMMs)已在多种任务(如图像描述、视觉问答)中展现出卓越能力

尽管知识面广泛,但其知识仍具有通用性(例如识别一只狗),无法处理个性化主体(例如识别用户的爱犬)。相比之下,人类推理通常围绕周围环境中的特定主体展开

本文中,我们提出了个性化LMM的新任务,使其能够围绕特定主体展开对话。我们提出了Yo’LLaVA,它能够根据少量主体示例图像,学习将个性化主体嵌入到一组潜在token中

定性与定量分析表明,与强提示基线(如LLaVA)相比,Yo’LLaVA能以更少的token更高效地学习概念,并更有效地编码视觉属性

1 Introduction

“xx在这张照片里做什么?”或”我想为xx买生日礼物,你有什么推荐?”这些问题看似简单,但现有的大型多模态模型(LMMs)并非为回答此类_个性化_问题而设计

虽然这些模型能利用广泛知识对图像中的物体和人进行分类,但它们无法将这些物体识别为用户 ...

MetaMorph:Multimodal Understanding and Generation via Instruction Tuning

MetaMorph:Multimodal Understanding and Generation via Instruction Tuning(通过指令微调实现多模态理解和生成)Abstract

在这项工作中,我们提出了视觉预测指令微调(Visual-Predictive Instruction Tuning, VPiT)——这是对视觉指令微调的一个简单而有效的扩展,它使得预训练的大语言模型(LLM)能够快速转变为一个统一的自回归模型,能够生成文本和视觉token

VPiT 教会LLM从任何以指令跟随格式整理的图像和文本数据输入序列中预测离散的文本token和连续的视觉token

实证研究揭示了VPiT的几个有趣特性:

视觉生成能力作为视觉理解能力提升的自然副产品出现,并且可以通过少量的生成数据高效解锁

虽然我们发现理解和生成是相互促进的,但理解数据对这两种能力的贡献比生成数据更有效

基于这些发现,我们训练了MetaMorph模型,并在视觉理解和生成方面取得了有竞争力的表现

在视觉生成方面,MetaMorph能够利用从LLM预训练中获得的世界知识和推理能力,并克服其他生成 ...

VARGPT: Unified Understanding and Generation in a Visual Autoregressive Multimodal Large Language Model

VARGPT: Unified Understanding and Generation in a Visual Autoregressive Multimodal Large Language Model(视觉自回归多模态大语言模型中的统一理解与生成)Abstract

VARGPT是一种新颖的多模态大语言模型(MLLM),它在单一的自回归框架内统一了视觉理解和生成

VARGPT采用下一个token预测范式进行视觉理解,采用下一个尺度预测范式进行视觉自回归生成

VARGPT创新性地扩展了LLaVA架构,在MLLMs中实现了高效的尺度自回归视觉生成,同时无缝地支持单一模型框架内的混合模态输入和输出

VARGPT经过三个阶段的一体化训练过程,包括预训练阶段和两个混合视觉指令微调阶段

统一训练策略旨在实现视觉和文本特征的对齐,增强理解和生成的指令跟随能力,并提高视觉生成质量

VARGPT自然地支持自回归视觉生成和指令到图像合成的能力,展示了其在视觉理解和生成任务中的多功能性

1. Introduction

近年来,多模态人工智能在理解和生成这两个核心领域取得了重大突破。多模态 ...

角色动画与运动仿真 05 Data-driven Character Animation

Motion CaptureThe History of Mocap

快速摄影

转描

现代动捕设备系统:

外骨骼

基于惯性

基于光学

Mechanical Mocap

外骨骼:

外骨骼的问题:影响人类运动

Inertial Mocap

惯性测量单元(IMU):Accelerometers (3dof) + axis gyroscope (3dof),可以通过积分得到位置和速度

问题:误差较大,精度高的传感器价格较高

还需要加入其他传感器:重力加速度传感器,电磁传感器

Optical MocapOptical Mocap

光学动捕:依靠光学设备采集标志点的位置

一般使用红外相机,精度高(毫米级)

计算点的位置:三角测量

问题:人的动作非常多非常复杂,可能造成遮挡,因而需要更多的相机进行测量

光学动捕只能得到标记点,之后还需labeling,进行补点

无需补点marker的方法:

Markerless Mocap with Multiple Cameras

Markerless Mocap with Depth Cameras

Motio ...